In komplexen IT-Landschaften von modernen Finanzinstituten ist das firmeninterne Wissen verteilt in Kernsystemen, Dokumenten, Datenbanken und E-Mails abgelegt. Wie kann dieses Wissen effektiv genutzt werden?

Wie grosse Mengen an Wissen verfügbar gemacht werden können, zeigen Large-Language-Modelle (LLM) wie GPT-4. Trainiert mit Millionen von öffentlich zugänglichen Quellen können sie komplexe Fragen beantworten. Wie können die Fähigkeiten von LLMs mit spezifischem Unternehmenswissen verbunden werden, um die Power von AI in die Kernprozesse von Finanzinstituten zu bringen?

Der ti&m AI Assistent

Die Antwort heisst ti&m AI Assistent. Anstatt aufwändig eigene Modelle zu trainieren, gibt der ti&m AI Assistant einem LLM wie GPT-4 oder Gemini bei Anfragen einen spezifischen Unternehmenskontext mit, um seine Intelligenz auf dieses Unternehmenswissen anzuwenden.

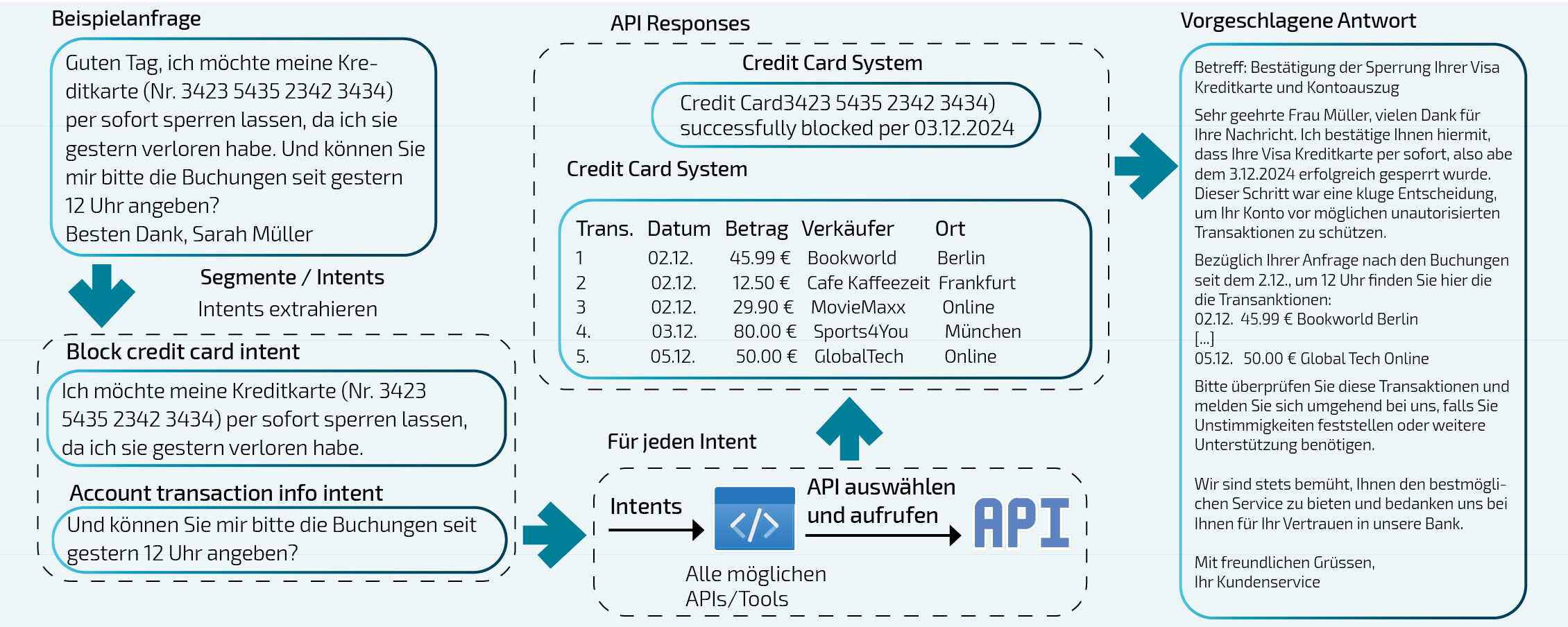

In der Abbildung sehen Sie das Vorgehen am Beispiel der Beantwortung einer Kundenanfrage via Messaging-System im E-Banking. Dabei werden kundenspezifische Daten wie Transaktionen oder Portfolio-Informationen genutzt, um die Anfrage zu beantworten. Diese Daten befinden sich oft nicht in einfachen Dokumenten, sondern in Kernsystemen wie dem Transaktionssystem. Um die Daten trotzdem nutzbar zu machen, können die LLMs sogenannte «Tools» wie APIs oder Browser nutzen. Das LLM entscheidet dabei selbst, welches Tool für welche Aufgabe geeignet ist. Hat sich das LLM entschieden, wird das Tool mit den entsprechenden Parametern aufgerufen (z.B. der Browser mit der URL XY) und die daraus resultierenden Daten werden vom LLM weiterverarbeitet:

1. Der Kunde sendet im authentifizierten E-Banking eine Nachricht, in welcher er um die Sperrung seiner Kreditkarte bittet. Gleichzeitig will er auch die Transaktionen der letzten 24 Stunden prüfen, um mögliche betrügerische Abbuchungen zu detektieren.

2. Das LLM analysiert die Nachricht und segmentiert diese in sogenannte «Intents» auf. In diesem Beispiel ist der erste Intent, die Karte zu sperren. Der zweite, Transaktionen abzufragen.

3. Nun prüft das LLM für jeden Intent, welches Tool es nutzen soll. Um die beste Auswahl zu treffen, steht dem LLM eine Übersicht aller Tools zur Verfügung.

4. In diesem Beispiel entscheidet sich das LLM:

a. Die Credit Card System API zur Blockierung der Karte aufzurufen. Dabei wird unter anderem die Kreditkartennummer aus der Nachricht übergeben.

b. Die Account Transaction Info API aufzurufen. Dabei wird die Time-Range (von/bis) übergeben, für welche die Transaktionen geladen werden sollen.

5. In einem letzten Schritt fügt das LLM die Antworten aus den verschiedenen API-Anfragen in eine kohärente Nachricht zusammen, die dem Kunden zurückgeschickt wird. Die Nachricht kann zusätzlich einen manuellen Check durchlaufen («Human-in-the-loop»).

Unbegrenzte Möglichkeiten

Das Beispiel ist nur eines von vielen, wie Finanzinstitutionen das Potenzial eines LLM im Kontext ihres Unternehmens nutzen können. Der ti&m AI Assistant unterstützt Mitarbeitende dabei, vorhandene Daten effizient und zielgerichtet zu nutzen, Prozesse zu automatisieren oder neue Produkte zu entwickeln. Die Kunden hingegen profitieren von einer unmittelbaren, sehr spezifischen und profunden Betreuung ihrer Anliegen.

Ursin Brunner, Head Machine Learning, ti&m